Laboratoire d’applications de la désinformation (Disinfo App Lab ou DAL) est une initiative à but non lucratif, dirigée par la Fondation de l’innovation numérique (FIN), avec une équipe de recherche internationale de 10 professeurs dans 7 pays, basée à Gatineau, Québec, Canada.

L’équipe se concentre sur les applications de l’intelligence artificielle (IA) pour aider à détecter et à surveiller un type très spécifique de désinformation : les fausses allégations contre les politiciens dans leurs rôles de gouvernance (par exemple, la corruption, les pots-de-vin, le népotisme, etc.) Les fausses nouvelles, qu’elles soient textuelles ou multimédias, peuvent cibler des projets du secteur public dans le but de ternir une initiative gouvernementale qui fonctionne bien par ailleurs. Cela crée des doutes et entraîne l’annulation de projets ou de programmes, privant ainsi les citoyens de services et entravant le développement national.

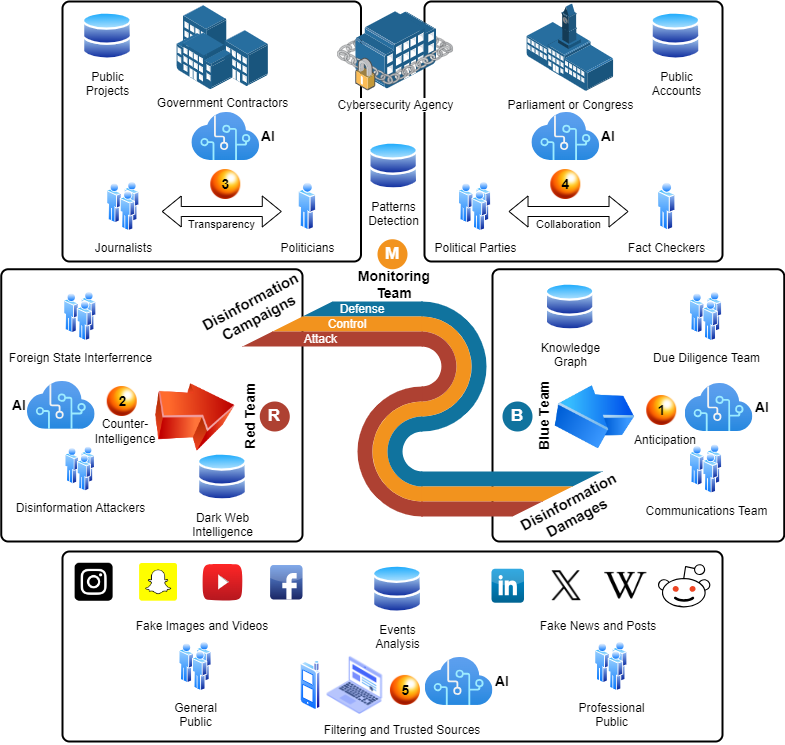

Le diagramme ci-dessous montre le large éventail d’acteurs, d’informations et de technologies impliqués. Nous identifions cinq domaines : (1) l’équipe bleue qui lutte contre les dommages causés par la désinformation ; (2) l’équipe rouge qui mène des campagnes de désinformation ; (3) les projets gouvernementaux ciblés ; (4) les parlements sur lesquels les attaques ont un impact ; (5) le public auquel la désinformation est diffusée. Les agences de cybersécurité et les équipes de surveillance sont « au milieu ».

En adoptant une perspective « campagne globale », la surveillance de la désinformation peut offrir au moins cinq fonctionnalités majeures : (1) anticipation des « prochains événements » dans une chaîne de fausses nouvelles, afin d’aider les équipes bleues à lutter plus stratégiquement ; (2) contre-espionnage sur les acteurs du web sombre pour dissuader et désarmer ; (3) amélioration de la transparence en reliant les informations sur les projets publics aux actions des politiciens et aux nouvelles officielles ; (4) collaboration entre les partis politiques et leur réseau de vérificateurs de faits, garantissant qu’aucune fausse information n’est propagée dans les parlements ou utilisée pour la prise de décision ; (5) systèmes de filtrage et de sources fiables pour aider les utilisateurs finaux, qu’il s’agisse du grand public ou de professionnels.

En 2025, l’équipe est en train de collecter des données d’études de cas sur plusieurs affaires de corruption, certaines où les allégations se sont avérées vraies, d’autres fausses. En outre, l’équipe développe de nouvelles ontologies et des graphes de connaissances (Knowledge Graphs, KG) pour aider à modéliser les campagnes de désinformation et les schémas d’attaque, qui seront ensuite intégrés dans les grands modèles de langage (Large Language Models, LLM) augmentés de graphes. Enfin, un ensemble de cas d’utilisation sera développé, en collaboration avec des experts en communication politique, qui aideront à identifier la meilleure façon d’utiliser l’IA, en particulier les KG et les LLM, pour surmonter l’impact de la désinformation dans leur travail, et assurer une diligence raisonnable plus rapide et plus précise pour résoudre les allégations de corruption à l’encontre des politiciens.