El Laboratorio de Aplicaciones de Desinformación (Disinfo App Lab o DAL) es una iniciativa sin fines de lucro, liderada por la Fundación para la Innovación Digital (FID), con un equipo internacional de investigación de 9 profesores en 6 países, con sede en Gatineau, Quebec, Canadá.

El equipo se centra en aplicaciones de Inteligencia Artificial (IA) para ayudar a detectar y monitorear un tipo muy específico de desinformación: acusaciones falsas contra políticos en sus funciones de gobierno (por ejemplo, corrupción, soborno, nepotismo, etc.). Las noticias falsas, ya sean textuales o multimedia, pueden afectar proyectos del sector público con el objetivo de empañar una iniciativa gubernamental que, por lo demás, funciona bien. Esto genera dudas y provoca la cancelación de proyectos o programas, privando así a los ciudadanos de servicios e impidiendo el desarrollo nacional.

- Por favor ver este resumen (2025-11-12), a presentation in Enblish ou une présentation en français.

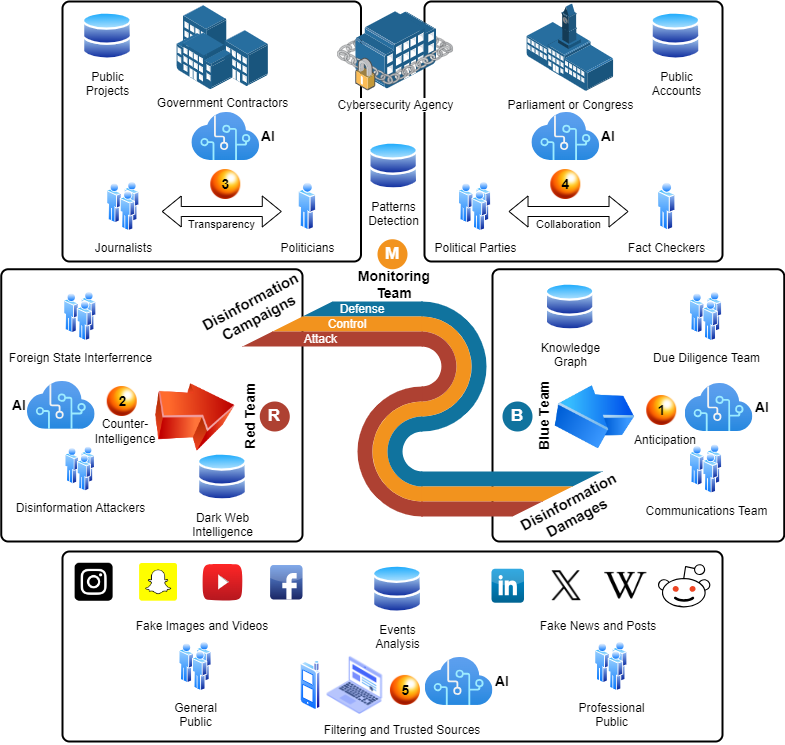

El diagrama a continuación muestra el amplio espectro de actores, información y tecnologías involucradas. Identificamos 5 áreas: (1) equipo azul que combate los daños causados por la desinformación; (2) equipo rojo que ejecuta campañas de desinformación; (3) proyectos gubernamentales objetivo; (4) parlamentos afectados por los ataques; (5) público al que se distribuye la desinformación. Las agencias de ciberseguridad y los equipos de monitoreo se encuentran en el centro.

Al adoptar una perspectiva integral de la campaña, el monitoreo de la desinformación puede proporcionar al menos cinco funciones principales: (1) anticipación de los próximos eventos en una cadena de noticias falsas, para ayudar a los equipos azules a combatir de forma más estratégica; (2) contrainteligencia sobre actores de la dark web para disuadir y desarmar; (3) mejora de la transparencia al vincular la información pública de los proyectos con las acciones de los políticos y las noticias oficiales; (4) colaboración entre los partidos políticos y su red de verificadores de datos, garantizando que no se propague información falsa en los parlamentos ni se utilice para la toma de decisiones; (5) sistemas de filtrado y fuentes confiables para apoyar a los usuarios finales, ya sean público general o profesionales.

En 2024, el equipo estaba recopilando datos de estudios de caso sobre varios casos de corrupción, algunos con acusaciones verdaderas y otros falsas. Además, el equipo desarrolla nuevas ontologías y grafos de conocimiento (KG) para modelar campañas de desinformación y patrones de ataque, que posteriormente se integrarán en Modelos de Lenguaje Grande (LLM) aumentados con grafos. Finalmente, se desarrollará un conjunto de casos de uso, en colaboración con expertos en comunicación política, quienes ayudarán a identificar la mejor manera de utilizar la IA, especialmente los KG y los LLM, para superar el impacto de la desinformación en su trabajo y garantizar una diligencia debida más rápida y precisa para resolver las acusaciones de corrupción contra políticos.